Nous testons les agents vocaux depuis 2 ans. Pendant longtemps, le verdict était toujours le même : « Impressionnant, mais pas prêt pour un vrai client. » Cela a changé fin 2025.

Nous avons testé en profondeur les dernières technologies et la différence est flagrante. Voici pourquoi les agents vocaux sont enfin prêts pour une adoption massive en 2026.

1. La Course Vers Zéro Latence : Natif vs. Modulaire

La pause gênante de trois secondes qui définissait l’IA vocale a disparu. En 2026, nous voyons la latence « bout-en-bout » passer sous les 300ms, égalant effectivement les temps de réaction humains. Cela a été rendu possible grâce à deux avancées techniques convergentes :

La Révolution Audio Native

Des modèles comme GPT-4o Realtime d’OpenAI et Gemini 2.0 Flash de Google ont dépassé l’ancien pipeline de « transcodage » (Speech-to-Text → Text → Text-to-Speech). Ces modèles traitent l’audio nativement. Ils entendent le ton, l’intonation et le débit directement, et répondent instantanément. Cette approche « multimodale » élimine le surcoût de traitement lié à la conversion parole-texte et retour.

La Stack Modulaire Hyper-Optimisée

Pour les développeurs qui préfèrent contrôler chaque composant, le pipeline modulaire est également devenu ultra-rapide. Le héros ici est Sonic-3 de Cartesia. Sorti fin 2025, Sonic-3 est un moteur de génération vocale qui atteint une latence impressionnante de 90ms.

En combinant des moteurs d’inférence ultra-rapides (comme Groq) avec le rendu vocal instantané de Sonic-3, les entreprises peuvent désormais construire des agents modulaires personnalisés aussi rapides que les géants natifs, mais avec plus de contrôle sur la voix et la logique.

2. Les Plateformes Sont Devenues des « Cerveaux d’Orchestration »

Autrefois, construire un agent vocal signifiait assembler des APIs en espérant que ça tienne. Aujourd’hui, des plateformes comme Vapi et ElevenLabs ont évolué en couches d’orchestration robustes qui gèrent le chaos de la téléphonie temps réel.

Vapi est devenu l’infrastructure de référence. Aucun verrouillage fournisseur : vous pouvez assembler votre pipeline et workflow comme des briques Lego, en changeant de modèles, voix et transcripteurs à volonté. Il gère le jitter des lignes téléphoniques, le « barge-in » (quand un utilisateur interrompt l’IA), et route les flux audio automatiquement.

ElevenLabs a dépassé le stade des « belles voix » pour devenir une stack Conversational AI complète. Leurs Agent Workflows permettent aux agents de conserver le contexte sur de longues conversations et de gérer une logique complexe sans cerveau séparé.

3. MCP : L’« USB-C » de la Connaissance d’Entreprise

La percée la plus significative pour 2026 est sans doute l’adoption massive du Model Context Protocol (MCP).

Jusqu’à récemment, connecter un agent vocal à vos données internes (CRM, inventaire, Notion) était un cauchemar d’intégration sur mesure et fragile. MCP a changé la donne. Il fournit un moyen standardisé pour l’IA de se connecter aux sources de données de manière sécurisée.

Connexion Universelle : Votre agent vocal n’a pas seulement des connaissances générales ; il a vos connaissances. Quand un client demande « Ma commande est-elle prête ? », l’agent interroge votre base de données SQL interne via un serveur MCP et répond immédiatement.

Le Pouvoir de la Réutilisabilité : C’est le game changer. Une fois qu’on construit un serveur MCP pour votre logique métier spécifique, il peut être réutilisé par tous vos agents IA. Votre Agent Vocal, votre Chatbot Web et votre Assistant Slack Interne partagent tous les mêmes outils et accès aux données. Construire une fois, déployer partout.

4. Hyper-Réalisme et Intelligence Émotionnelle

Le monotone robotique est mort. La dernière génération de modèles possède une capacité « Speech-to-Speech », ce qui signifie qu’ils comprennent et reproduisent les nuances.

Cartesia Sonic-3 a introduit un contrôle émotionnel fin. On peut maintenant diriger l’agent pour « soupirer », « rire » ou parler avec « urgence » via de simples tags. Si un client semble frustré, l’IA détecte la prosodie et ajuste sa réponse pour être plus empathique, automatiquement. (Cartesia Sonic)

Mises à jour ElevenLabs v3 : ElevenLabs a redéfini les attentes avec leur mise à jour v3, nous donnant le contrôle sur la performance via des Audio Tags, permettant de diriger un agent pour [chuchoter] un secret ou [faire une pause] pour l’effet. (ElevenLabs v3)

Parité Mondiale : Les voix de haute qualité ne sont plus exclusives à l’anglais. Les modèles français et même néerlandais se rapprochent maintenant de la qualité anglaise, ouvrant la porte aux déploiements mondiaux.

Nous avons testé ces agents avec nos clients dans divers scénarios. Les retours sont extrêmement positifs, et les équipes rapportent un gain de temps énorme en déléguant les appels routiniers à l’IA.

Applications Pratiques pour 2026

La technologie n’est plus le frein. L’opportunité réside maintenant dans l’application.

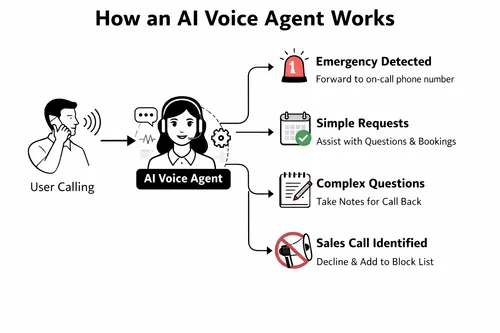

La Fin du Répondeur (Le Réceptionniste IA) : C’est le ROI le plus immédiat pour la plupart des entreprises. Un réceptionniste IA peut fonctionner en deux modes :

- Gardien Hors-Heures : Au lieu d’un répondeur générique, l’agent décroche à 18h, répond aux questions et prend des rendez-vous directement dans votre calendrier.

- Accueil à Temps Plein : Pour les entreprises à fort volume, il gère 100% des appels initiaux, filtrant le spam et traitant les FAQ de routine pour que vos humains ne parlent qu’aux leads qualifiés.

Autres cas d’usage : Qualification de leads sortants, prise de rendez-vous, et bases de connaissances vocales pour les techniciens terrain.

Conclusion

La stack technologique pour l’IA vocale a mûri. 2026 ne sera pas l’année d’attendre que la tech s’améliore ; ce sera l’année de la créativité que les entreprises appliqueront à ces outils. La latence a disparu, les voix sont réelles, et les connexions de données sont standardisées.

Chez Flowful.ai, nous pouvons vous aider à construire des agents vocaux sur mesure et à intégrer vos données via MCP.